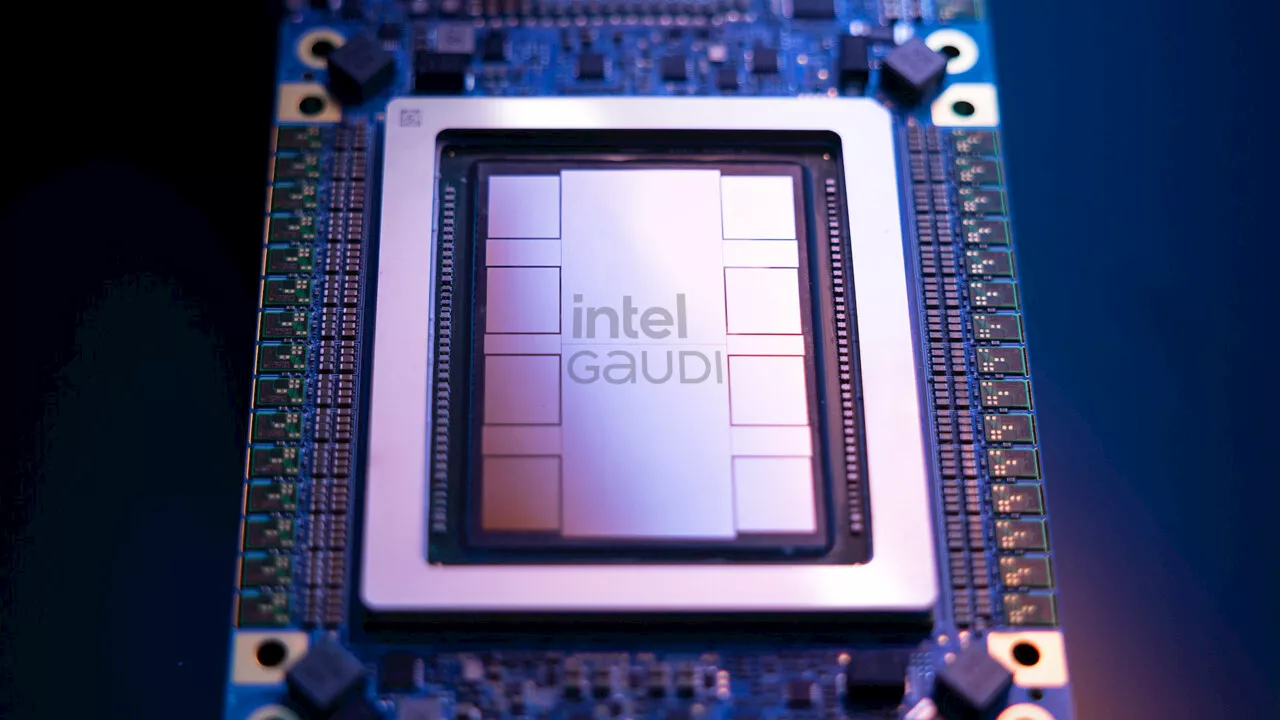

Intel stellt seine neue Generation KI-Beschleuniger aus der Schmiede Habana Labs vor: Die Gaudi-3-Beschleuniger sollen viel schneller als Nvidias H100 sein.

Kunden abjagen und kommt außer als Open Accelerator Module auch im Achterpack auf einem Universal Baseboard und als herkömmliche PCI-Express-Steckkarte mit bis zu 600 Watt Thermal Design Power . Die OAM-Version schluckt laut Intel bis zu 900 Watt beim KI-Training.

Die Gaudi-3-Beschleuniger liefert Intel bereits in Musterstückzahlen aus, die Massenproduktion soll für die luftgekühlte OAM-Version im dritten Quartal 2024 starten, die flüssiggekühlte Option kommt ein Vierteljahr später. Anfangs werden die Chips in Geräten von Dell, HPE, Lenovo und Supermicro landen, im dritten Quartal erwartet Intel breitere Verfügbarkeit.

Intel KI-Beschleuniger KI-Training Künstliche Intelligenz

Italia Ultime Notizie, Italia Notizie

Similar News:Puoi anche leggere notizie simili a questa che abbiamo raccolto da altre fonti di notizie.

AI-Beschleuniger Gaudi3: Der nächste Herausforderer für Nvidia H100/H200 und B200Gaudi2 feierte Achtungserfolge, Gaudi3 soll nun als erster echter AI-Beschleuniger von Intel noch weitergehen und Nvidia nicht nur kitzeln.

AI-Beschleuniger Gaudi3: Der nächste Herausforderer für Nvidia H100/H200 und B200Gaudi2 feierte Achtungserfolge, Gaudi3 soll nun als erster echter AI-Beschleuniger von Intel noch weitergehen und Nvidia nicht nur kitzeln.

Leggi di più »

PlayStation 5 Pro: Gerüchte um Hybrid-GPU mit RDNA-4-RT und KI-BeschleunigerMit welcher Hardware wird die PlayStation 5 Pro aufwarten? Mit dieser Frage beschäftigt sich die Gerüchteküche immer konkreter.

PlayStation 5 Pro: Gerüchte um Hybrid-GPU mit RDNA-4-RT und KI-BeschleunigerMit welcher Hardware wird die PlayStation 5 Pro aufwarten? Mit dieser Frage beschäftigt sich die Gerüchteküche immer konkreter.

Leggi di più »

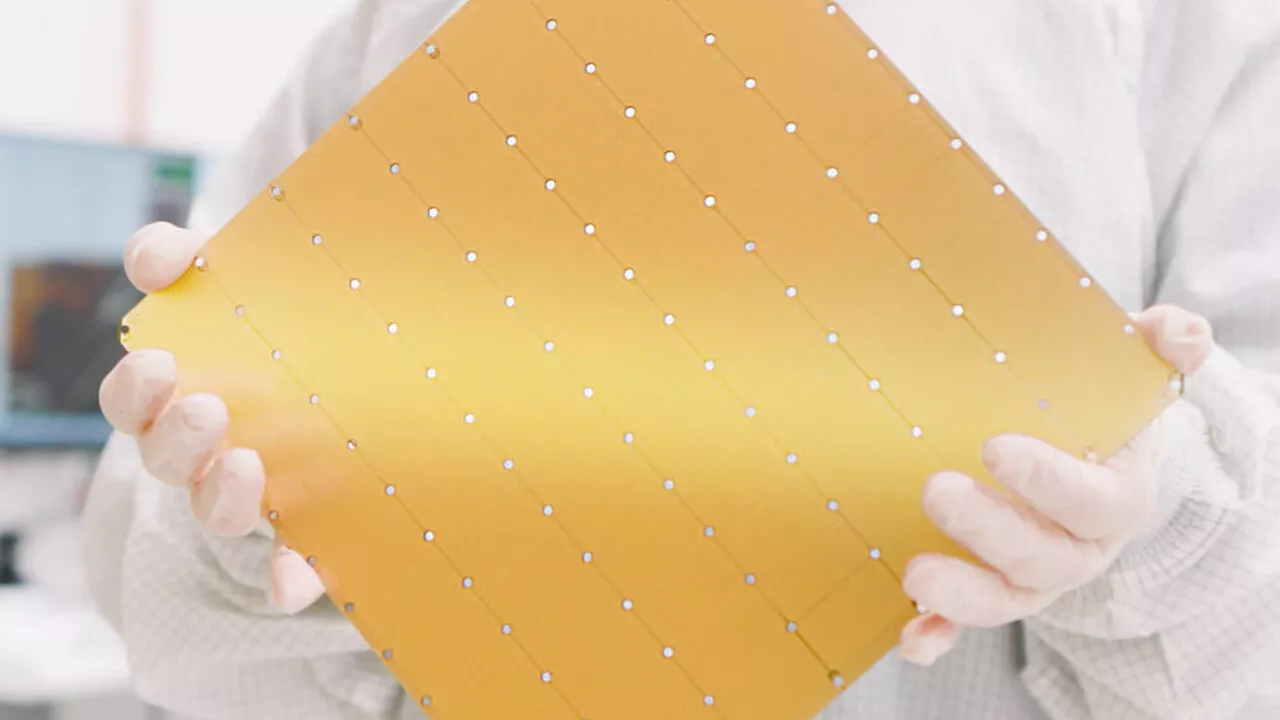

Cerebras stellt die dritte Generation des AI-Beschleunigers CS-3 vorDas auf AI-Beschleuniger und entsprechende Hyperscaler spezialisierte Unternehmen Cerebras hat mit dem CS-3 auf Basis der WSE-3 heute die dritte Generation in Wafergröße vorgestellt. Der Prozessor hat praktisch die Größe eines Wafers und kommt deshalb auf 4 Billionen Transistoren. Der auserkorene Gegner heißt Nvidia H100. Im Wettrennen um immer leistungsfähigere AI-Beschleuniger für das Training und Inferencing von Large Language Models (LLM) geht Cerebras mit der WSE-3 (Wafer-Scale Engine) den nächsten Schritt.

Cerebras stellt die dritte Generation des AI-Beschleunigers CS-3 vorDas auf AI-Beschleuniger und entsprechende Hyperscaler spezialisierte Unternehmen Cerebras hat mit dem CS-3 auf Basis der WSE-3 heute die dritte Generation in Wafergröße vorgestellt. Der Prozessor hat praktisch die Größe eines Wafers und kommt deshalb auf 4 Billionen Transistoren. Der auserkorene Gegner heißt Nvidia H100. Im Wettrennen um immer leistungsfähigere AI-Beschleuniger für das Training und Inferencing von Large Language Models (LLM) geht Cerebras mit der WSE-3 (Wafer-Scale Engine) den nächsten Schritt.

Leggi di più »

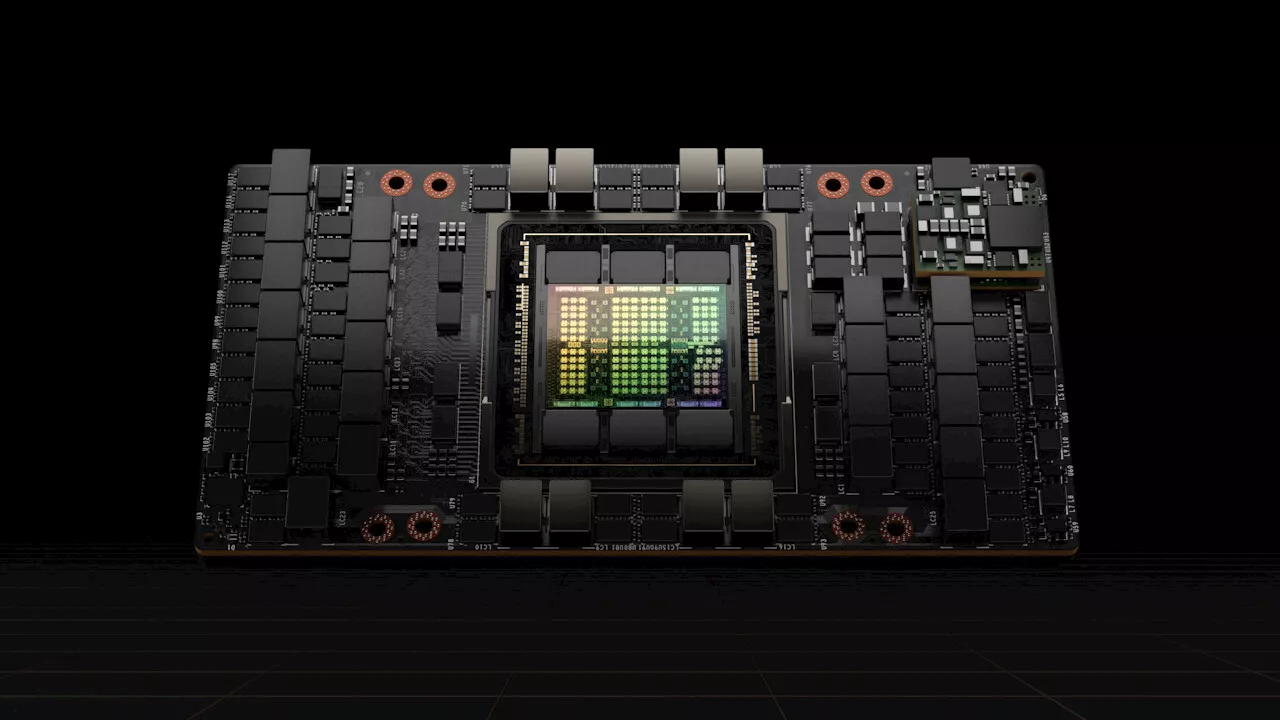

AI-Rechenleistung: Metas neue AI-Cluster nutzen jeweils 24.576 Nvidia H100Meta will bis Ende 2024 insgesamt 350.000 Nvidia H100 nutzen. Zwei neue Cluster mit jeweils 24.576 GPUs dieses Typs sind jetzt am Netz.

AI-Rechenleistung: Metas neue AI-Cluster nutzen jeweils 24.576 Nvidia H100Meta will bis Ende 2024 insgesamt 350.000 Nvidia H100 nutzen. Zwei neue Cluster mit jeweils 24.576 GPUs dieses Typs sind jetzt am Netz.

Leggi di più »

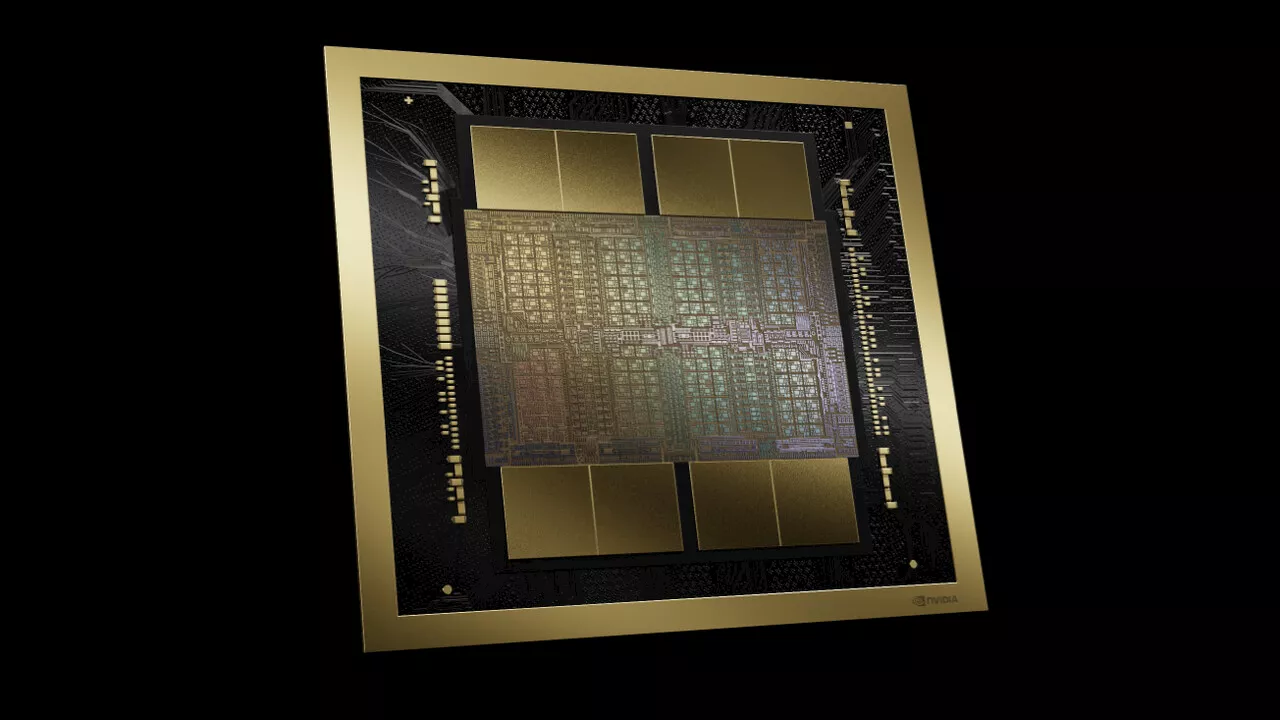

Nvidia Blackwell: B200-GPU kommt als Dual-Die mit 208 Milliarden TransistorenBlackwell ist Nvidias neue Architektur für AI-Beschleuniger. Die B200-GPU besteht aus zwei Dies, die ein Chip-to-Chip-Link verbindet.

Nvidia Blackwell: B200-GPU kommt als Dual-Die mit 208 Milliarden TransistorenBlackwell ist Nvidias neue Architektur für AI-Beschleuniger. Die B200-GPU besteht aus zwei Dies, die ein Chip-to-Chip-Link verbindet.

Leggi di più »

Geforce RTX 5090: Nvidias nächstes Flaggschiff soll deutlich schneller werden als die RTX 5080Aktuelle Gerüchte deuten an, welche Leistungsverhältnisse bei Nvidias kommenden Top-Modellen der RTX-5000-Generation herrschen könnten.

Geforce RTX 5090: Nvidias nächstes Flaggschiff soll deutlich schneller werden als die RTX 5080Aktuelle Gerüchte deuten an, welche Leistungsverhältnisse bei Nvidias kommenden Top-Modellen der RTX-5000-Generation herrschen könnten.

Leggi di più »